Por Waldemir Cambiucci. 03 de novembro de 2025.

Durante o último AI Summit Brasil 2025, tivemos uma sessão muito especial com amigo e pesquisador Beny Rubinstein, falando sobre um tema que pegou muitos de surpresa: Machine Unlearning ou Desaprendizado de Máquina.

Ele começou com um desafio interessante, veja o elefantinho abaixo:

Viu? Agora tenta esquecer ele! Conseguiu!? 😉Pois é!

Desde setembro, venho explorando esse assunto, suas aplicações e impacto, também pela direta conexão com outro tema igualmente importante: Responsible AI.

E assim, trago aqui um breve bate-papo sobre o assunto, falando de conceitos, aplicações, benefícios e desafios de mais essa linha de pesquisa no universo da Inteligência Artificial. Bora lá!?

Introdução

O rápido avanço da Inteligência Artificial (IA) e do Machine Learning (ML) nos últimos 20 anos transformou diversos setores da sociedade ao permitir automação inteligente, interações homem-máquina mais amigáveis, tomada de decisões mais precisa e previsões baseadas em grandes volumes de dados. E desde 2022, vivemos um novo tempo ao redor dos modelos de IA generativa, transformadores e LLMs, suportando cenários de inferências sobre grandes volumes de dados, extração de significado, busca, geração de conteúdo personalizado, tudo disparado através do poder de uma interface baseada em linguagem natural. Mais recentemente, agentes de IA aceleram ainda mais o processo de geração e consumo de dados em todas as indústrias, criando uma nova forma de pensar e implementar linhas de negócios.

Contudo, essa evolução também trouxe preocupações sobre privacidade, uso indevido de informações e conformidade com regulamentações. Vivemos uma grande discussão sobre Segurança da Informação na Era da IA desde 2014, quando os primeiros encontros sobre AI Safe surgiram.

Nesse contexto surge o machine unlearning, conceito que trata da capacidade de sistemas de IA removerem seletivamente dados ou conhecimentos adquiridos, sem a necessidade de treinar o modelo novamente desde o início.

Ou seja, como fazer uma IA esquecer nosso elefantinho do começo do artigo? 😉

A Necessidade do Desaprendizado em Sistemas de IA

Com a coleta massiva de dados, muitos modelos acabam utilizando informações que podem ser sensíveis, incorretas ou legalmente proibidas.

Machine unlearning é necessário para garantir que sistemas de IA respeitem leis como o “direito ao esquecimento”, removam vieses prejudiciais ou excluam dados de usuários que retiram consentimento. Sem esse recurso, as empresas enfrentam riscos legais, éticos e reputacionais.

Definição e Conceitos-Chave

Machine unlearning pode ser definido como o processo pelo qual um modelo de IA “desaprende” informações específicas previamente incluídas em seu treinamento. Isso vai além da simples exclusão de dados do banco original, ou seja, envolve garantir que o conhecimento derivado desses dados também seja apagado do modelo. Por isso, o desafio é grande, como veremos adiante.

Outros conceitos também presentes nessa técnica são “forget sets” (conjuntos de dados a serem esquecidos), “retain sets” (dados que devem permanecer) e métodos que tornam o modelo incapaz de reproduzir ou ser influenciado pelas informações esquecidas.

Arquitetura de Machine Unlearning

A arquitetura de sistemas de machine unlearning geralmente combina técnicas de particionamento de dados, modelos modulares e ajustes finos no modelo treinado. Particionamento de dados é algo que me interessa muito, pelas abordagens gráficas e hipergráficas envolvidas. Heurísticas diversas de particionamento hipergráfico podem ser aplicadas, garantindo a segmentação de dados relacionados ou agrupados em hiperarestas do hipergrafo, por exemplo, de um domínio de conhecimento específico.

Explicando um pouco mais, heurísticas hipergráficas de particionamento podem ser empregadas no machine unlearning como uma forma eficiente de identificar e isolar regiões de influência dos dados que precisam ser esquecidos dentro de um modelo. Nessa abordagem, os dados de treinamento, parâmetros do modelo e gradientes são representados em um hipergráfico, no qual cada hiperaresta conecta múltiplos elementos que interagem entre si durante o aprendizado. O particionamento desse hipergráfico permite dividir o modelo em subestruturas ou componentes que compartilham similaridade de influência ou dependência. Assim, ao receber uma solicitação de remoção de um dado específico, é possível localizar apenas a partição do hipergráfico na qual esse dado exerce influência significativa e aplicar o unlearning de maneira localizada. Isso evita o retrabalho completo do modelo, reduz o consumo de recursos computacionais e mantém a consistência geral do desempenho. A teoria de Grafos e Hipergrafos é bem grande, mas igualmente sensacional! Recomendo! 🙂

Assim, em vez de treinar tudo novamente, o que pode ser economicamente inviável em muitos casos, o sistema pode isolar as partes do modelo associadas aos dados que devem ser removidos. Isso pode ser feito por meio de um re-treinamento parcial, de um aprendizado reverso ou através do uso de métodos que rastreiam a contribuição de cada dado no resultado final do modelo.

E assim, nasce uma linha de pesquisa grandiosa e promissora, em torno do desafio de fazer modelos de IA esquecerem de forma economicamente viável.

Aplicações para Machine Unlearning

O machine unlearning é aplicável em diferentes contextos, como redes sociais que precisam excluir completamente dados de usuários, sistemas de recomendação que devem remover preferências ou referências antigas, áreas médicas que necessitam apagar registros sensíveis e modelos financeiros que precisam eliminar dados fraudulentos, para citar apenas alguns cenários.

Também é útil para reduzir vieses identificados em grandes massas de dados, corrigindo erros no treinamento e atualizando modelos com segurança.

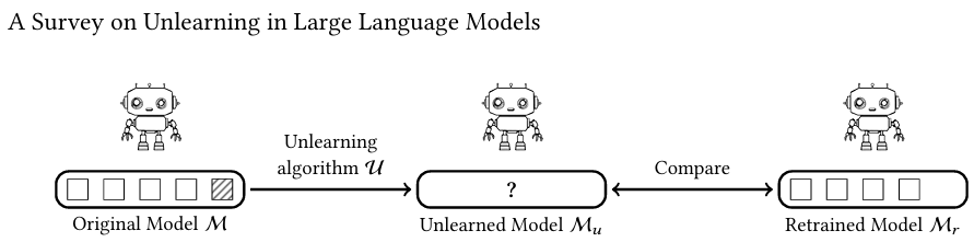

Fonte: arXiv preprint arXiv:2510.25117

Diferenças entre Desaprendizado, Exclusão e Esquecimento

Aqui, vale enfatizar algumas diferenças entre temas relacionados. Quando pensamos em excluir dados significa apenas que iremos removê-los de bancos de dados, sem afetar o conhecimento já aprendido pelo modelo. De modo semelhante, esquecimento de dados pode ser mais natural, como quando informações perdem relevância com o passar do tempo e novas referências deixam de existir sobre esses dados.

Já o machine unlearning é um processo ativo e controlado que remove, de forma comprovável, qualquer influência de certos dados no comportamento do modelo de IA. Ou seja, o modelo não deve mais ser capaz de se comportar como se esses dados tivessem existido. Veja a profundidade e o impacto disso para diferentes cenários de negócios e aplicações.

Motivações do Mundo Real: GDPR, CCPA e IA Responsável

Leis como a General Data Protection Regulation (GDPR), a Lei Geral de Proteção de Dados (LGPD) ou a California Consumer Privacy Act (CCPA) asseguram aos cidadãos o direito de pedir que seus dados sejam apagados. Além disso, princípios de IA Responsável exigem transparência, respeito à privacidade, segurança e redução de discriminações. Esses comportamentos em grande maioria estão atrelados aos dados utilizados durante o treinamento dos modelos.

Assim, o machine unlearning torna-se essencial para atender essas exigências, ajudando empresas a evitarem multas, aumentar a confiança do público e construir sistemas mais responsáveis. Também aplicamos machine unlearning como ferramenta de eliminação de dados envenenados, defesa de copyrights ou mesmo eliminação de dados ofensivos, presentes na base de treinamento dos modelos.

Desafios e Limitações

Apesar de promissor, o machine unlearning enfrenta desafios técnicos importantes, como garantir que o esquecimento seja completo, sem comprometer a performance do modelo ou gerar novos vieses. Também pode ser caro e complexo rastrear como cada dado influenciou o modelo, ao longo de diversos ciclos de treinamento. Há ainda dificuldades em validar legalmente se o esquecimento realmente aconteceu, o que demanda métodos auditáveis e transparentes de avaliação dos modelos de IA envolvidos.

Para ilustrar, coloquei no final do artigo uma lista de Papers e pesquisas em andamento sobre diferentes técnicas e métodos de realização de machine unlearning. Você vai logo notar que todos os trabalhos são de 2024/2025 e que diferentes métodos estão sendo explorados, perseguindo os desafios e objetivos apresentados aqui no texto.

Conclusões

O machine unlearning representa um passo importante para tornar a IA mais segura, ética e alinhada às regulamentações. Embora ainda em desenvolvimento, a tecnologia oferece soluções práticas para privacidade, correção de erros e governança de dados.

Podemos esperar novos investimentos e muita pesquisa sobre padrões, novas técnicas e ferramentas de machine unlearning sobre modelos de IA, para um futuro com sistemas de IA cada vez mais confiáveis e responsáveis.

Faz sentido? Agora só não vale esquecer tudo o que você leu nesse artigo! 😉

Para saber mais, veja a lista a seguir de alguns artigos interessantes e recentes sobre machine unlearning, confira:

- LANYON, Jamie et al. On the limitation of evaluating machine unlearning using only a single training seed. arXiv preprint arXiv:2510.26714, 2025. https://arxiv.org/abs/2510.26714

- QIU, Ruichen et al. A Survey on Unlearning in Large Language Models. arXiv preprint arXiv:2510.25117, 2025. https://arxiv.org/abs/2510.25117

- PANG, Zirui et al. Label Smoothing Improves Gradient Ascent in LLM Unlearning. arXiv preprint arXiv:2510.22376, 2025. https://arxiv.org/abs/2510.22376

- WANG, Weiqi et al. Machine unlearning: A comprehensive survey. arXiv preprint arXiv:2405.07406, 2024. https://arxiv.org/abs/2405.07406

- SHI, Weijia et al. Muse: Machine unlearning six-way evaluation for language models. arXiv preprint arXiv:2407.06460, 2024. https://arxiv.org/abs/2407.06460