Pesquisadores chineses descobriram uma limitação significativa em modelos de raciocínio, como o DeepSeek-R1 e o OpenAI o1. Esses modelos de IA tendem a abandonar prematuramente estratégias promissoras ao enfrentar tarefas complexas, um fenômeno conhecido como “underthinking”.

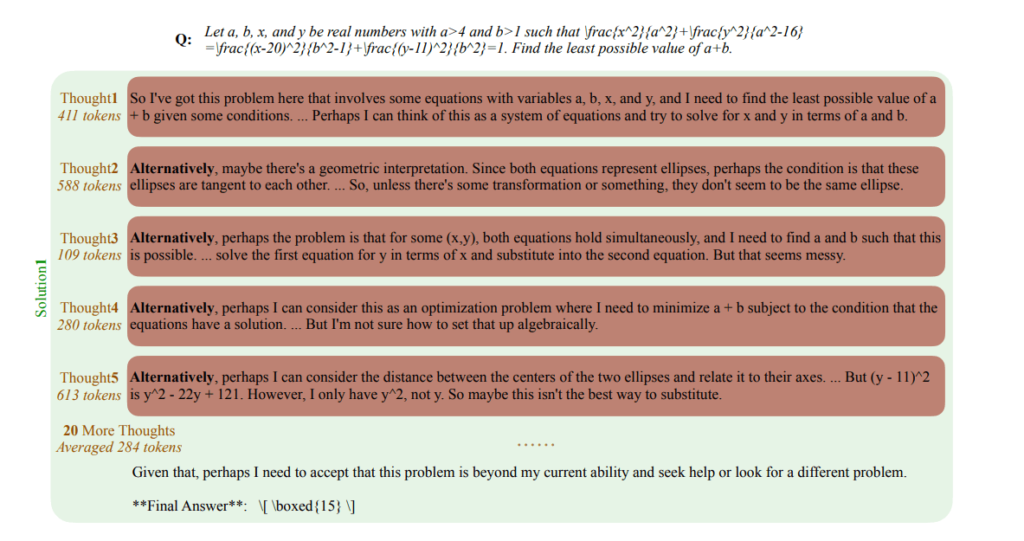

O “underthinking” ocorre quando o modelo muda rapidamente de abordagem, sem explorar completamente uma linha de raciocínio válida. Esse comportamento resulta em perda de eficiência e redução da precisão das respostas. O estudo mostra que essa tendência se intensifica à medida que a dificuldade das tarefas aumenta.

Impacto do “underthinking” na eficiência dos modelos

O “underthinking” afeta diretamente o desempenho dos modelos de raciocínio. Os pesquisadores observaram que cerca de 70% das respostas incorretas apresentavam, em algum momento, uma linha de raciocínio válida que foi interrompida prematuramente.

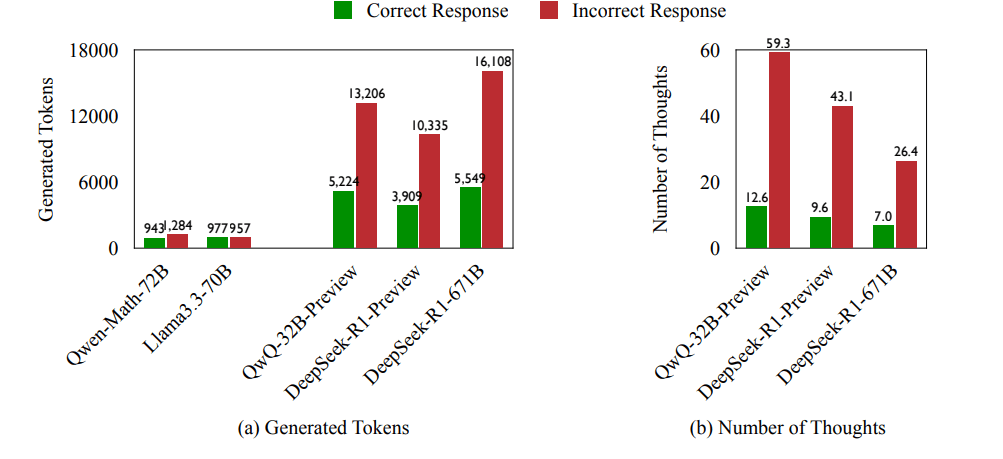

Além disso, quando esses modelos fornecem respostas erradas, eles consomem até 225% mais tokens computacionais do que quando acertam. Isso significa que gastam mais recursos sem obter um resultado melhor. O número de mudanças de estratégia também é 418% maior em respostas incorretas.

Essa ineficiência representa um desafio importante, especialmente em aplicações que dependem de alta precisão e economia de recursos, como em pesquisas científicas, diagnósticos médicos e análises financeiras.

Como o estudo avaliou a eficiência dos modelos

Para medir o impacto do “underthinking”, os pesquisadores desenvolveram uma métrica específica. Ela avalia o uso de tokens computacionais durante o processo de resposta, analisando quantos tokens foram realmente úteis antes de o modelo mudar de estratégia.

O estudo utilizou conjuntos de problemas desafiadores em áreas como matemática, física universitária e química. Modelos de IA avançados, como o QwQ-32B-Preview e o DeepSeek-R1-671B, foram testados para verificar a eficiência no raciocínio.

Os resultados confirmaram que modelos baseados em raciocínio, como o OpenAI o1, apresentam uma tendência a mudar de abordagem com muita frequência, o que leva ao desperdício de recursos e a uma menor taxa de acertos.

Proposta de solução: o método “Thought Switching Penalty” (TIP)

Para resolver o problema do “underthinking”, os pesquisadores propuseram uma abordagem inovadora chamada “Thought Switching Penalty” (TIP). Esse método visa desencorajar o modelo de IA a mudar de estratégia de forma precipitada.

O TIP funciona ajustando as probabilidades de certos tokens que indicam uma mudança de raciocínio, como palavras do tipo “alternativamente” ou “por outro lado”. Com isso, o modelo tende a explorar melhor uma linha de raciocínio antes de considerar outras possibilidades.

Após a implementação do TIP, o modelo QwQ-32B-Preview apresentou melhorias significativas. A taxa de acerto em problemas matemáticos complexos aumentou de 82,8% para 84,3%. Além disso, o modelo demonstrou um raciocínio mais consistente, reduzindo o desperdício de tokens computacionais.

O futuro dos modelos de raciocínio com IA

O estudo destaca a importância de aprimorar os modelos de raciocínio para que eles possam lidar melhor com tarefas complexas. Embora o TIP tenha se mostrado eficaz, ele representa apenas um dos primeiros passos na busca por soluções mais robustas para o “underthinking”.

Modelos de IA mais eficientes podem trazer benefícios significativos em diversas áreas, como saúde, finanças e pesquisa acadêmica. Com a evolução dessas tecnologias, espera-se que futuras versões desses modelos sejam capazes de manter um raciocínio mais profundo, explorando melhor cada abordagem antes de mudar de estratégia.

Conclusão: desafios e avanços no raciocínio da IA

O “underthinking” é um desafio real para o desenvolvimento de modelos de raciocínio avançados. No entanto, estudos como este mostram que é possível identificar e corrigir essas limitações. O método TIP demonstrou que pequenas mudanças na forma como os modelos processam informações podem levar a grandes melhorias em eficiência e precisão.

À medida que a pesquisa em IA avança, espera-se que novas soluções surjam para tornar esses modelos ainda mais inteligentes e eficazes. O futuro da inteligência artificial depende da capacidade de superar desafios como o “underthinking”, tornando a tecnologia cada vez mais confiável e poderosa.

Fonte: The Decoder